報警配置功能提供統一管理容器報警場景的功能,包括容器服務異常事件報警、集群相關基礎資源的關鍵指標報警、集群核心組件及集群中應用的指標報警。支持在創建集群時默認開啟報警功能。容器服務的報警規則支持通過集群內部署CRD的方式配置管理。本文介紹容器服務報警中心功能使用場景、如何接入報警功能,以及專有集群如何授予報警功能資源的訪問權限等。

背景信息

容器服務報警管理包含的功能:

功能使用場景

容器服務報警配置功能集合容器場景的監控報警能力,提供報警的統一配置管理,有如下幾個典型的使用場景:

集群運維

可以通過監控報警了解集群管控、存儲、網絡、彈性擴縮容等異常事件。例如:

通過集群資源異常報警規則集感知集群基礎資源的關鍵指標是否異常。例如,CPU、Memory、網絡等關鍵指標是否出現高水位情況,避免影響集群穩定性。

通過配置并查看集群異常事件報警規則集感知集群節點或容器節點異常。例如,集群節點Docker進程異常、集群節點進程異常及集群容器副本啟動失敗等異常。

通過配置并查看集群存儲異常事件報警規則集感知集群存儲的變更與異常。

通過配置并查看集群網絡異常事件報警規則集感知集群網絡的變更與異常。

通過配置并查看集群管控運維異常報警規則集感知集群管控的變更與異常等。

應用開發

可以通過監控報警了解在集群中運行應用的異常事件、指標是否異常。例如,集群容器副本異常或者應用Deployment的CPU、內存水位指標是否超過閾值等。可通過開啟報警配置功能中的默認報警規則模板,即可快速接收集群內應用容器副本的異常事件報警通知。例如,通過配置并訂閱關注集群容器副本異常報警規則集感知所屬應用的Pod是否異常。

應用管理

關注運行在集群上的應用健康、容量規劃、集群運行穩定性及異常甚至是錯誤報警等貫穿應用生命周期的一系列問題。例如,通過配置并訂閱關注集群重要事件報警規則集感知集群內所有Warning、Error等異常報警;關注集群資源異常報警規則集感知集群的資源情況,從而更好地做容量規劃等。

多集群管理

當您有多個集群需要管理,為集群配置報警規則往往會是一個重復繁瑣且難以同步的操作。容器服務報警配置功能,支持通過集群內部署CRD配置的方式管理報警規則。可通過維護多個集群中同樣配置的CRD資源,來方便快捷地實現多集群中報警規則的同步配置。

組件安裝與升級

控制臺會自動檢測報警配置環境是否符合要求,并會引導進行開通或安裝、升級組件。

登錄容器服務管理控制臺。

在控制臺左側導航欄,單擊集群。

在集群列表頁面,單擊目標集群名稱或者目標集群右側操作列下的詳情。

在集群管理頁左側導航欄,選擇。

在報警配置頁面控制臺會自動檢查以下條件。

若不符合條件,請按以下提示完成操作。

已開通SLS日志服務云產品。當您首次使用日志服務時,需要登錄日志服務控制臺,根據頁面提示開通日志服務。

說明關于日志服務的詳細計費,請參見按使用功能付費模式計費項。

已安裝事件中心。具體操作,請參見事件監控。

集群托管組件alicloud-monitor-controller升級到最新版本。更多信息,請參見alicloud-monitor-controller。

如何接入報警配置功能

目前容器服務報警規則配置功能支持ACK托管版集群、ACK專有版集群。

步驟一:開啟默認報警規則

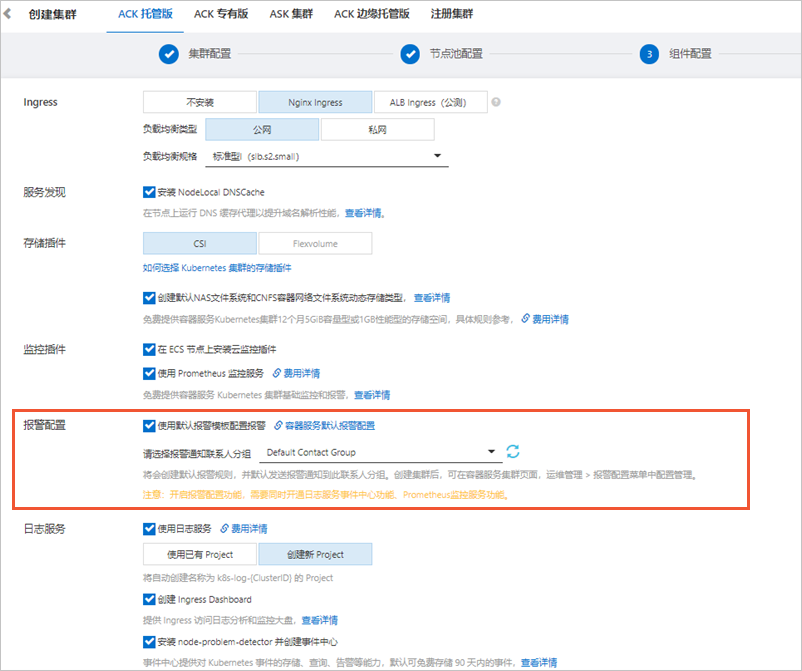

創建ACK托管版集群時,打開使用默認報警模板配置報警開關,并選擇報警通知聯系人分組。

開啟后將會創建默認報警規則,并默認發送報警通知到此聯系人分組。

具體操作,請參見創建Kubernetes托管版集群。

若已創建集群,可在目標集群開啟對應報警規則。

在目標集群左側導航欄選擇配置管理。

在報警規則管理頁簽,打開啟動狀態可開啟對應報警規則集。

具體操作,請參見步驟二:手動配置報警規則。

具體操作,請參見步驟二:手動配置報警規則。

步驟二:手動配置報警規則

ACK托管版集群、ACK專有版集群創建后,可進行報警規則、聯系人和聯系人分組管理。

登錄容器服務管理控制臺。

在控制臺左側導航欄,單擊集群。

在集群列表頁面,單擊目標集群名稱或者目標集群右側操作列下的詳情。

在集群管理頁左側導航欄,選擇。

功能特性

說明

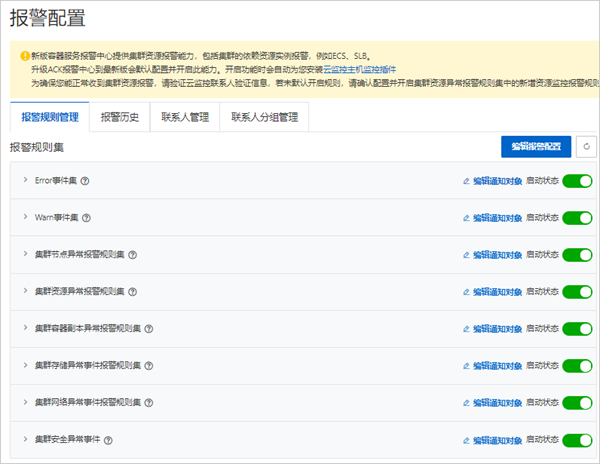

報警規則管理

容器服務報警規則功能會默認生成容器場景下的報警模板(包含異常事件報警、異常指標報警)。

報警規則被分類為若干個報警規則集,可為報警規則集關聯多個聯系人分組,并啟動或關閉報警規則集。

報警規則集中包含多個報警規則,一個報警規則對應單個異常的檢查項。多個報警規則集可以通過一個YAML資源配置到對應集群中,修改YAML會同步生成報警規則。

關于報警規則YAML配置,請參見如何通過CRD配置報警規則。

關于默認報警規則模板,請參見默認報警規則模板。

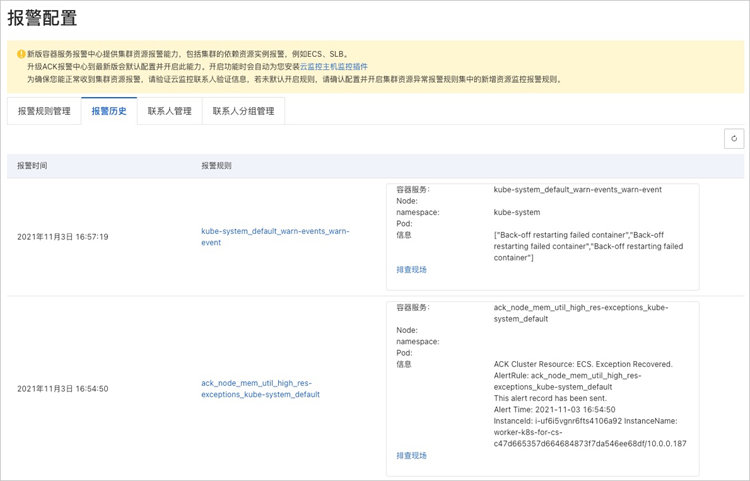

報警歷史

目前可查看最近發送的近100條歷史記錄。單擊報警規則列下的鏈接,可以跳轉到對應監控系統中查看詳細規則配置;單擊排查現場,可以快速定位到異常發生的資源頁面(異常事件、指標異常的資源)。

聯系人管理

對聯系人進行管理,可創建、編輯或刪除聯系人。

集群資源異常報警規則集中集群節點基礎資源報警,聯系人短信、郵箱等聯系方式需要在云監控中先驗證聯系方式,才能正常接收集群基礎資源報警信息。可在云監控控制臺查看同步聯系人,若驗證信息過期,可刪除云監控中對應聯系人并重新刷新容器服務報警中心的聯系人頁面。

聯系人分組管理

對聯系人分組進行管理,可創建、編輯或刪除聯系人分組。當無聯系人分組時,控制臺會從您的阿里云賬號注冊信息中同步創建一個默認聯系人分組。

在報警規則管理頁簽,單擊編輯通知對象可設置關聯的通知對象;打開啟動狀態可開啟對應報警規則集。

如何通過CRD配置報警規則

報警配置功能開啟時,會默認在kube-system Namespace下創建一個AckAlertRule類型的資源配置,包含默認報警規則模板。容器服務報警規則集可通過此資源配置在集群中。

登錄容器服務管理控制臺。

在控制臺左側導航欄,單擊集群。

在集群列表頁面,單擊目標集群名稱或者目標集群右側操作列下的詳情。

在集群管理頁左側導航欄,選擇。

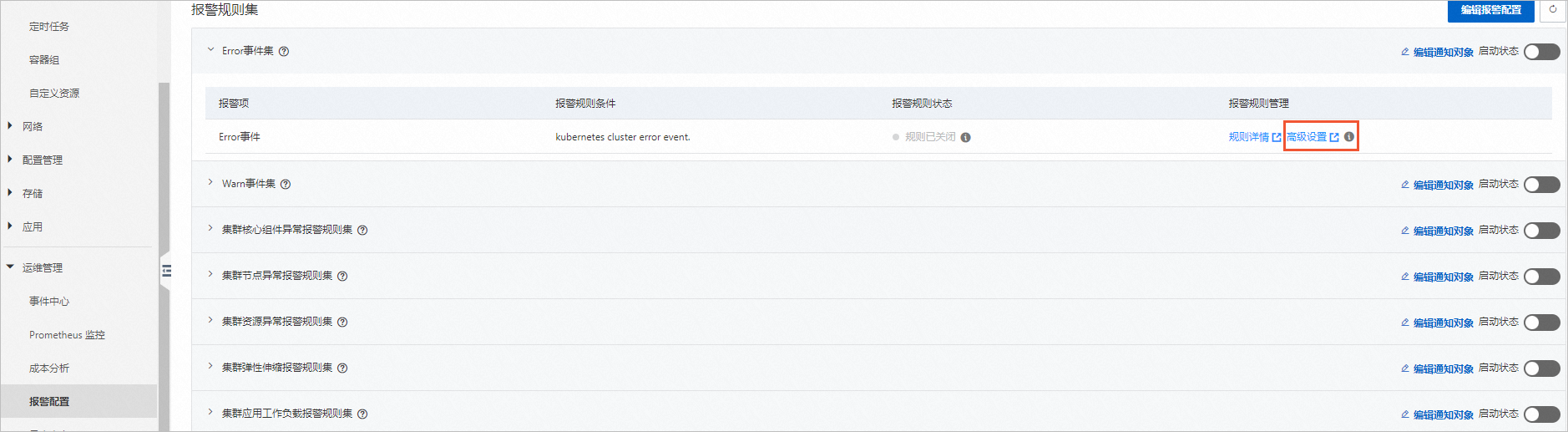

在報警規則管理頁簽中,單擊右上角編輯報警配置,可查看當前集群中的AckAlertRule資源配置,并可通過YAML文件修改。

報警規則配置的YAML文件示例如下:

apiVersion: alert.alibabacloud.com/v1beta1 kind: AckAlertRule metadata: name: default spec: groups: #以下是一個集群事件報警規則配置樣例。 - name: pod-exceptions #報警規則分組名,對應報警模板中的Group_Name字段。 rules: - name: pod-oom #報警規則名。 type: event #報警規則類型(Rule_Type),枚舉值為event(事件類型)、metric-cms(云監控指標類型)。 expression: sls.app.ack.pod.oom #報警規則表達式,當規則類型為event時,表達式的值為本文默認報警規則模板中Rule_Expression_Id值。 enable: enable #報警規則開啟狀態,枚舉值為enable、disable。 - name: pod-failed type: event expression: sls.app.ack.pod.failed enable: enable #以下是一個集群基礎資源報警規則配置樣例。 - name: res-exceptions #報警規則分組名,對應報警模板中的Group_Name字段。 rules: - name: node_cpu_util_high #報警規則名。 type: metric-cms #報警規則類型(Rule_Type),枚舉值為event(事件類型)、metric-cms(云監控指標類型)。 expression: cms.host.cpu.utilization #報警規則表達式,當規則類型為metric-cms時,表達式的值為本文默認報警規則模板中Rule_Expression_Id值。 contactGroups: #報警規則映射的聯系人分組配置,由ACK控制臺生成,同一個賬號下聯系人相同,可在多集群中復用。 enable: enable #報警規則開啟狀態,枚舉值為enable、disable。 thresholds: #報警規則閾值,詳情見文檔如何更改報警規則閾值部分。 - key: CMS_ESCALATIONS_CRITICAL_Threshold unit: percent value: '1'

默認報警規則模板

在以下情況下ACK會默認創建相應報警規則:

開啟默認報警規則功能。

未開啟默認報警規則,首次進入報警規則頁面。

默認創建的報警規則如下表所示。

規則集類型 | 規則名 | 規則說明 | Rule_Type | ACK_CR_Rule_Name | SLS_Event_ID |

critical-events集群重要事件報警規則集 | 集群Error事件 | 集群中所有Error Level異常事件觸發該報警。 | event | error-event | sls.app.ack.error |

集群Warn事件 | 集群中關鍵Warn Level異常事件觸發該報警,排除部分可忽略事件。 | event | warn-event | sls.app.ack.warn | |

cluster-error集群異常事件報警規則集 | 集群節點Docker進程異常 | 集群中節點Dockerd或Containerd 運行時異常。 | event | docker-hang | sls.app.ack.docker.hang |

集群驅逐事件 | 集群中發生驅逐事件。 | event | eviction-event | sls.app.ack.eviction | |

集群GPU的XID錯誤事件 | 集群中GPU XID異常事件。 | event | gpu-xid-error | sls.app.ack.gpu.xid_error | |

集群節點下線 | 集群中節點下線。 | event | node-down | sls.app.ack.node.down | |

集群節點重啟 | 集群中節點重啟。 | event | node-restart | sls.app.ack.node.restart | |

集群節點時間服務異常 | 集群中節點時間同步系統服務異常。 | event | node-ntp-down | sls.app.ack.ntp.down | |

集群節點PLEG異常 | 集群中節點PLEG異常。 | event | node-pleg-error | sls.app.ack.node.pleg_error | |

集群節點進程異常 | 集群中節點進程數異常。 | event | ps-hang | sls.app.ack.ps.hang | |

res-exceptions集群資源異常報警規則集 | 集群節點-CPU使用率≥85% | 集群中節點實例CPU使用率超過水位。默認值85%。 剩余資源不足15%時,可能會超過容器引擎層CPU資源預留。更多信息,請參見節點資源預留策略。這可能引起高頻CPU Throttle,最終嚴重影響進程響應速度。請及時優化CPU使用情況或調整閾值。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | node_cpu_util_high | cms.host.cpu.utilization |

集群節點-內存使用率≥85% | 集群中節點實例內存使用率超過水位。默認值85%。 剩余資源不足15%時,若仍然使用,水位將超過容器引擎層內存資源預留。更多信息,請參見節點資源預留策略。此場景下,Kubelet將發生強制驅逐行為。請及時優化內存使用情況或調整閾值。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | node_mem_util_high | cms.host.memory.utilization | |

集群節點-磁盤使用率≥85% | 集群中節點實例磁盤使用率超過水位。默認值85%。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | node_disk_util_high | cms.host.disk.utilization | |

集群節點-公網流出帶寬使用率≥85% | 集群中節點實例公網流出帶寬使用率超過水位。默認值85%。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | node_public_net_util_high | cms.host.public.network.utilization | |

集群節點-inode使用率≥85% | 集群中節點實例inode使用率超過水位。默認值85%。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | node_fs_inode_util_high | cms.host.fs.inode.utilization | |

集群資源-負載均衡最大連接數使用率≥85% | 集群中負載均衡實例最大連接數超過水位。默認值85%。 說明 負載均衡實例,即API-Server、Ingress所關聯的SLB負載均衡實例。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | slb_qps_util_high | cms.slb.qps.utilization | |

集群資源-負載均衡網絡流出帶寬使用率≥85% | 集群中負載均衡實例網絡流出帶寬使用率超過水位。默認值85%。 說明 負載均衡實例,即API-Server、Ingress所關聯的SLB負載均衡實例。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | slb_traff_tx_util_high | cms.slb.traffic.tx.utilization | |

集群資源-負載均衡最大連接數使用率≥85% | 集群中負載均衡實例最大連接數使用率超過水位。默認值85%。 說明 負載均衡實例,即API-Server、Ingress所關聯的SLB負載均衡實例。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | slb_max_con_util_high | cms.slb.max.connection.utilization | |

集群資源-負載均衡監聽每秒丟失連接數持續≥1 | 集群中負載均衡實例每秒丟失連接數持續超過水位。默認值1次。 說明 負載均衡實例,即API-Server、Ingress所關聯的SLB負載均衡實例。 關于如何調整閾值,請參見如何修改集群基礎資源報警規則的閾值。 | metric-cms | slb_drop_con_high | cms.slb.drop.connection | |

集群節點文件句柄過多 | 集群中節點文件句柄數過多異常。 | event | node-fd-pressure | sls.app.ack.node.fd_pressure | |

集群節點磁盤空間不足 | 集群中節點磁盤空間不足異常事件。 | event | node-disk-pressure | sls.app.ack.node.disk_pressure | |

集群節點進程數過多 | 集群中節點進程數過多異常事件。 | event | node-pid-pressure | sls.app.ack.node.pid_pressure | |

集群節點調度資源不足 | 集群中無調度資源異常事件。 | event | node-res-insufficient | sls.app.ack.resource.insufficient | |

集群節點IP資源不足 | 集群中IP資源不足異常事件。 | event | node-ip-pressure | sls.app.ack.ip.not_enough | |

pod-exceptions集群容器副本異常報警規則集 | 集群容器副本OOM | 集群容器副本Pod或其中進程出現OOM(Out of Memory)。 | event | pod-oom | sls.app.ack.pod.oom |

集群容器副本啟動失敗 | 集群容器副本Pod啟動失敗事件(Pod Start Failed)。 | event | pod-failed | sls.app.ack.pod.failed | |

集群鏡像拉取失敗事件 | 集群容器副本Pod出現鏡像拉取失敗事件。 | event | image-pull-back-off | sls.app.ack.image.pull_back_off | |

cluster-ops-err集群管控運維異常報警規則集 | 無可用LoadBalancer | 集群無法創建LoadBalancer事件。請提交工單聯系容器服務團隊。 | event | slb-no-ava | sls.app.ack.ccm.no_ava_slb |

同步LoadBalancer失敗 | 集群創建LoadBalancer同步失敗事件。請提交工單聯系容器服務團隊。 | event | slb-sync-err | sls.app.ack.ccm.sync_slb_failed | |

刪除LoadBalancer失敗 | 集群刪除LoadBalancer失敗事件。請提交工單聯系容器服務團隊。 | event | slb-del-err | sls.app.ack.ccm.del_slb_failed | |

刪除節點失敗 | 集群刪除節點失敗事件。請提交工單聯系容器服務團隊。 | event | node-del-err | sls.app.ack.ccm.del_node_failed | |

添加節點失敗 | 集群添加節點失敗事件。請提交工單聯系容器服務團隊。 | event | node-add-err | sls.app.ack.ccm.add_node_failed | |

創建VPC網絡路由失敗 | 集群創建VPC網絡路由失敗事件。請提交工單聯系容器服務團隊。 | event | route-create-err | sls.app.ack.ccm.create_route_failed | |

同步VPC網絡路由失敗 | 集群同步VPC網絡路由失敗事件。請提交工單聯系容器服務團隊。 | event | route-sync-err | sls.app.ack.ccm.sync_route_failed | |

托管節點池命令執行失敗 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-run-cmd-err | sls.app.ack.nlc.run_command_fail | |

托管節點池未提供任務的具體命令 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-empty-cmd | sls.app.ack.nlc.empty_task_cmd | |

托管節點池出現未實現的任務模式 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-url-m-unimp | sls.app.ack.nlc.url_mode_unimpl | |

托管節點池發生未知的修復操作 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-opt-no-found | sls.app.ack.nlc.op_not_found | |

托管節點池銷毀節點發生錯誤 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-des-node-err | sls.app.ack.nlc.destroy_node_fail | |

托管節點池節點排水失敗 | 集群托管節點池排水異常事件。請提交工單聯系容器服務團隊。 | event | nlc-drain-node-err | sls.app.ack.nlc.drain_node_fail | |

托管節點池重啟ECS未達到終態 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-restart-ecs-wait | sls.app.ack.nlc.restart_ecs_wait_fail | |

托管節點池重啟ECS失敗 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-restart-ecs-err | sls.app.ack.nlc.restart_ecs_fail | |

托管節點池重置ECS失敗 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-reset-ecs-err | sls.app.ack.nlc.reset_ecs_fail | |

托管節點池自愈任務失敗 | 集群托管節點池異常事件。請提交工單聯系容器服務團隊。 | event | nlc-sel-repair-err | sls.app.ack.nlc.repair_fail | |

cluster-network-err集群網絡異常事件報警規則集 | Terway資源無效 | 集群Terway網絡資源無效異常事件。請提交工單聯系容器服務團隊。 | event | terway-invalid-res | sls.app.ack.terway.invalid_resource |

Terway分配IP失敗 | 集群Terway網絡資源分配IP失敗異常事件。請提交工單聯系容器服務團隊。 | event | terway-alloc-ip-err | sls.app.ack.terway.alloc_ip_fail | |

解析Ingress帶寬配置失敗 | 集群Ingress網絡解析配置異常事件。請提交工單聯系容器服務團隊。 | event | terway-parse-err | sls.app.ack.terway.parse_fail | |

Terway分配網絡資源失敗 | 集群Terway網絡資源分配失敗異常事件。請提交工單聯系容器服務團隊。 | event | terway-alloc-res-err | sls.app.ack.terway.allocate_failure | |

Terway回收網絡資源失敗 | 集群Terway網絡資源回收失敗異常事件。請提交工單聯系容器服務團隊。 | event | terway-dispose-err | sls.app.ack.terway.dispose_failure | |

Terway虛擬模式變更 | 集群Terway網絡虛擬模式變更事件。 | event | terway-virt-mod-err | sls.app.ack.terway.virtual_mode_change | |

Terway觸發PodIP配置檢查 | 集群Terway網絡觸發PodIP配置檢查事件。 | event | terway-ip-check | sls.app.ack.terway.config_check | |

Ingress重載配置失敗 | 集群Ingress網絡配置重載異常事件。請檢查Ingress配置是否正確。 | event | ingress-reload-err | sls.app.ack.ingress.err_reload_nginx | |

cluster-storage-err集群存儲異常事件報警規則集 | 云盤容量少于20 GiB限制 | 集群網盤固定限制,無法掛載小于20 GiB的磁盤。請檢查所掛載云盤的容量大小。 | event | csi_invalid_size | sls.app.ack.csi.invalid_disk_size |

容器數據卷暫不支持包年包月類型云盤 | 集群網盤固定限制,無法掛載包年包月類型的云盤。請檢查所掛載云盤的售賣方式。 | event | csi_not_portable | sls.app.ack.csi.disk_not_portable | |

掛載點正在被進程占用,卸載掛載點失敗 | 集群存儲掛載點正在被進程占用,卸載掛載點失敗。 | event | csi_device_busy | sls.app.ack.csi.deivce_busy | |

無可用云盤 | 集群存儲掛載時無可用云盤異常。請提交工單聯系容器服務團隊。 | event | csi_no_ava_disk | sls.app.ack.csi.no_ava_disk | |

云盤IOHang | 集群出現IOHang異常。請提交工單聯系容器服務團隊。 | event | csi_disk_iohang | sls.app.ack.csi.disk_iohang | |

磁盤綁定的PVC發生slowIO | 集群磁盤綁定的PVC發生slowIO異常。請提交工單聯系容器服務團隊。 | event | csi_latency_high | sls.app.ack.csi.latency_too_high | |

磁盤容量超過水位閾值 | 集群磁盤使用量超過水位值異常。請檢查您的集群磁盤水位情況。 | event | disk_space_press | sls.app.ack.csi.no_enough_disk_space | |

security-err集群安全異常事件 | 安全巡檢發現高危風險配置 | 集群安全巡檢發現高危風險配置事件。請提交工單聯系容器服務團隊。 | event | si-c-a-risk | sls.app.ack.si.config_audit_high_risk |

如何為專有版集群授予報警功能訪問權限

專有版集群在使用報警規則功能之前,需要手動添加權限。

托管版集群已自動添加SLS報警功能資源的訪問權限。

為專有版集群SLS報警功能及ARMS-Prometheus報警功能授予資源訪問權限。更多信息,請參見RAM自定義授權場景及訪問控制概述。

登錄容器服務管理控制臺。

在控制臺左側導航欄,單擊集群。

在集群列表頁面,單擊目標集群名稱或者目標集群右側操作列下的詳情。

在集群信息頁面,單擊集群資源頁簽Worker RAM角色字段右側的鏈接,進入RAM訪問控制控制臺。

在角色頁面的權限管理頁簽,單擊對應權限策略名稱的鏈接。

在策略內容頁簽單擊修改策略內容,然后將以下內容添加到策略內容中。

{ "Action": [ "log:*", "arms:*", "cms:*", "cs:UpdateContactGroup" ], "Resource": [ "*" ], "Effect": "Allow" }單擊繼續編輯基本信息,然后單擊確定完成配置。

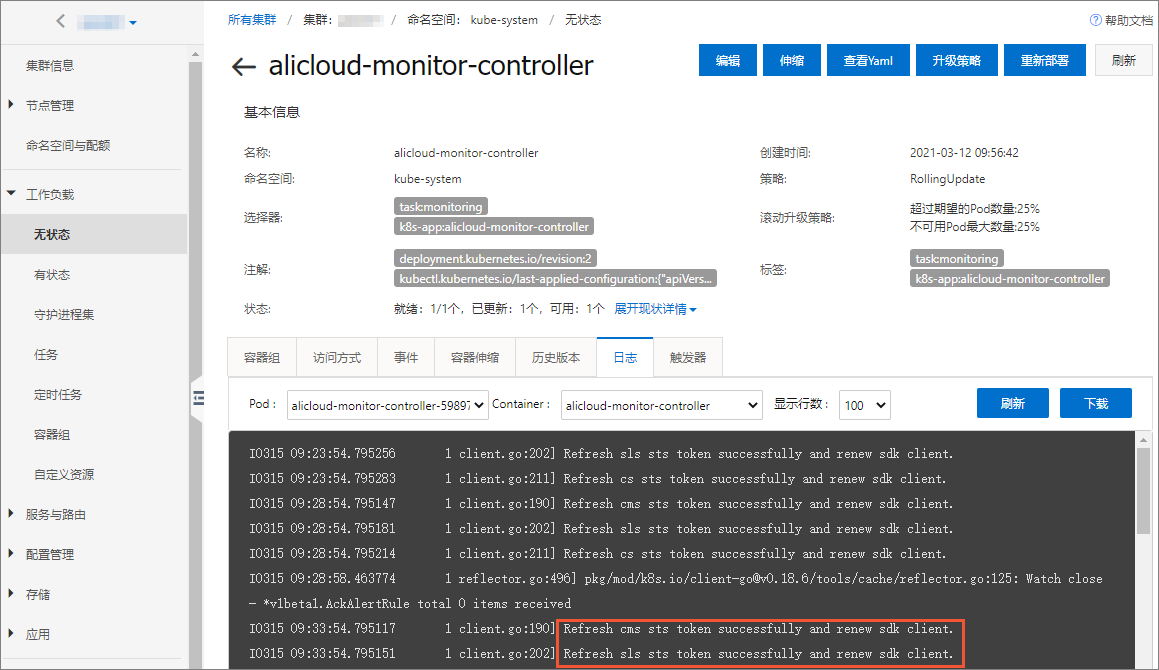

通過日志查看報警功能訪問權限是否已配置。

在容器服務管理控制臺目標集群管理頁左側導航欄,選擇。

選擇命名空間kube-system,單擊無狀態應用列表中alicloud-monitor-controller的名稱鏈接。

單擊日志頁簽,可看到授權成功的Pod日志。

如何修改集群基礎資源報警規則的閾值

Rule_Type為metric-cms的報警規則,是同步自云監控的基礎資源報警規則,此類規則可通過CRD配置報警規則的閾值。具體操作,請參見如何通過CRD配置報警規則。

本示例通過集群節點-CPU使用率規則的報警規則CRD,增加thresholds參數配置基礎監控報警規則的閾值、重試判斷次數、靜默期配置。

apiVersion: alert.alibabacloud.com/v1beta1

kind: AckAlertRule

metadata:

name: default

spec:

groups:

#以下是一個集群基礎資源報警規則配置樣例。

- name: res-exceptions #報警規則分組名,對應報警模板中的Group_Name字段。

rules:

- name: node_cpu_util_high #報警規則名。

type: metric-cms #報警規則類型(Rule_Type),枚舉值為event(事件類型)、metric-cms(云監控指標類型)。

expression: cms.host.cpu.utilization #報警規則表達式,當規則類型為metric-cms時,表達式的值為本文默認報警規則模板中Rule_Expression_Id值。

contactGroups: #報警規則映射的聯系人分組配置,由ACK控制臺生成,同一個賬號下聯系人相同,可在多集群中復用。

enable: enable #報警規則開啟狀態,枚舉值為enable、disable。

thresholds: #報警規則閾值,更多信息,請參見如何通過CRD配置報警規則。

- key: CMS_ESCALATIONS_CRITICAL_Threshold

unit: percent

value: '1'

- key: CMS_ESCALATIONS_CRITICAL_Times

value: '3'

- key: CMS_RULE_SILENCE_SEC

value: '900' 參數名 | 說明 | 默認值 |

| 報警配置閾值。

此參數必填,未配置時規則將同步失敗并關閉。 | 根據默認報警模板配置而定。 |

| 云監控規則重試判斷次數。 可選參數,未配置時取默認值。 | 3 |

| 云監控持續發送異常觸發規則時,初次上報報警后靜默期時長(單位:秒),防止過于頻繁報警。 可選參數,未配置時取默認值。 | 900 |

如何在對應監控系統中查看ACK報警中心報警規則

當開啟ACK報警中心的默認報警規則后,同步成功即可在報警規則中,通過單擊高級設置,分別跳轉到此規則的監控系統(ARMS/SLS/CMS)服務的報警規則設置頁面。或直接進入對應監控系統,查看此報警規則的詳細配置。

日志服務的報警規則:

登錄日志服務控制臺。

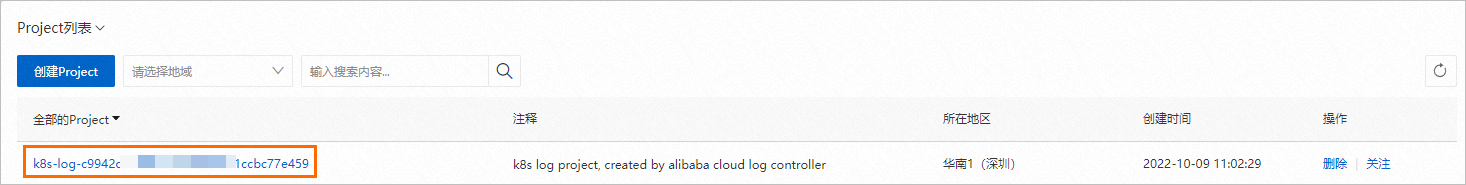

搜索并進入此集群日志服務對應的Project。集群默認日志服務Project命名為K8s-log-{{clusterId}}。

在左側導航欄,單擊

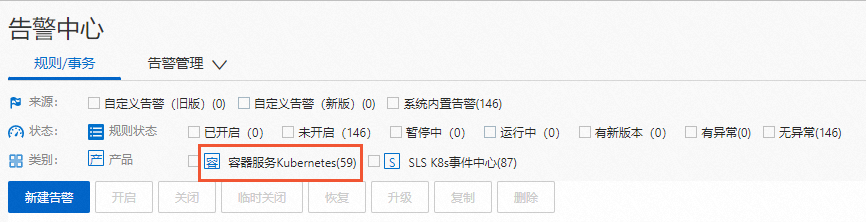

圖標,在告警中心頁面中,單擊規則/事務頁簽,查看已開啟的規則。類別選擇容器服務Kubernetes,可篩選展示ACK報警中心同步的此集群的默認報警規則。說明

圖標,在告警中心頁面中,單擊規則/事務頁簽,查看已開啟的規則。類別選擇容器服務Kubernetes,可篩選展示ACK報警中心同步的此集群的默認報警規則。說明需要您開啟ACK報警中心的報警規則,否則無法顯示類別。

云監控報警規則:

登錄云監控控制臺。

在左側導航欄,單擊應用分組,在應用分組列表頁面,單擊資源標簽規則頁簽。

在規則描述列,查找資源標簽鍵:ack.aliyun.com,資源標簽值:等于為<集群ID>的規則。

Prometheus報警規則:登錄ARMS控制臺,查看ACK報警中心在此集群已經同步的Prometheus報警規則。報警規則名在Prometheus控制臺中以

報警規則名_集群名展示。

常見問題

報警規則同步失敗且報錯信息為The Project does not exist : k8s-log-xxx

問題現象:

當報警中心中報警規則同步狀態出現如下情況:

問題原因:

未創建SLS事件中心資源。

解決方案:

在日志服務管理控制臺檢查Project是否達到Quota上限,刪除多余的Project,或提交工單申請擴大Project資源Quota限制。關于如何刪除Project,請參見管理Project。

重新安裝ack-node-problem-detector組件。

在容器服務管理控制臺目標集群管理頁左側導航欄中,選擇。

若您需要通過YAML方式重新安裝ack-node-problem-detector組件,請通過以下操作備份ack-node-problem-detector組件資源。

在Helm頁面,單擊ack-node-problem-detector組件右側操作列的更新。更新完成后,單擊ack-node-problem-detector組件右側操作列詳情。在ack-node-problem-detector組件詳情頁,單擊所有資源信息的查看YAML,并保存各資源的YAML到本地。

在Helm頁面,單擊ack-node-problem-detector組件右側操作列的刪除。

在集群管理頁左側導航欄中,選擇。

單擊日志與監控頁簽,在ack-node-problem-detector組件的卡片中單擊安裝。

在提示對話框中確認版本信息后單擊確定。安裝成功后,對應組件卡片區域會提示已安裝,且可查看組件當前版本。

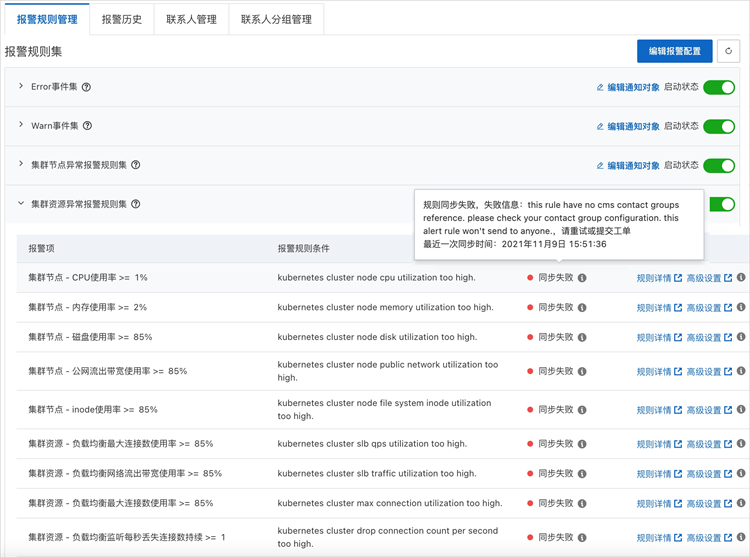

由于無訂閱的聯系人組導致報警規則同步失敗

問題現象:

當報警中心中報警規則同步狀態出現如下情況:

報錯信息為類似信息:this rule have no xxx contact groups reference。

問題原因:

報警規則無訂閱的聯系人組。

解決方案:

已創建聯系人,并將聯系人加入聯系人分組中。

在對應報警規則集右側單擊編輯通知對象,為該組報警規則配置訂閱的聯系人分組。

關于上述操作的詳情,請參見如何接入報警配置功能。