本文介紹KServe的基本概念以及如何部署KServe。

索引

KServe介紹

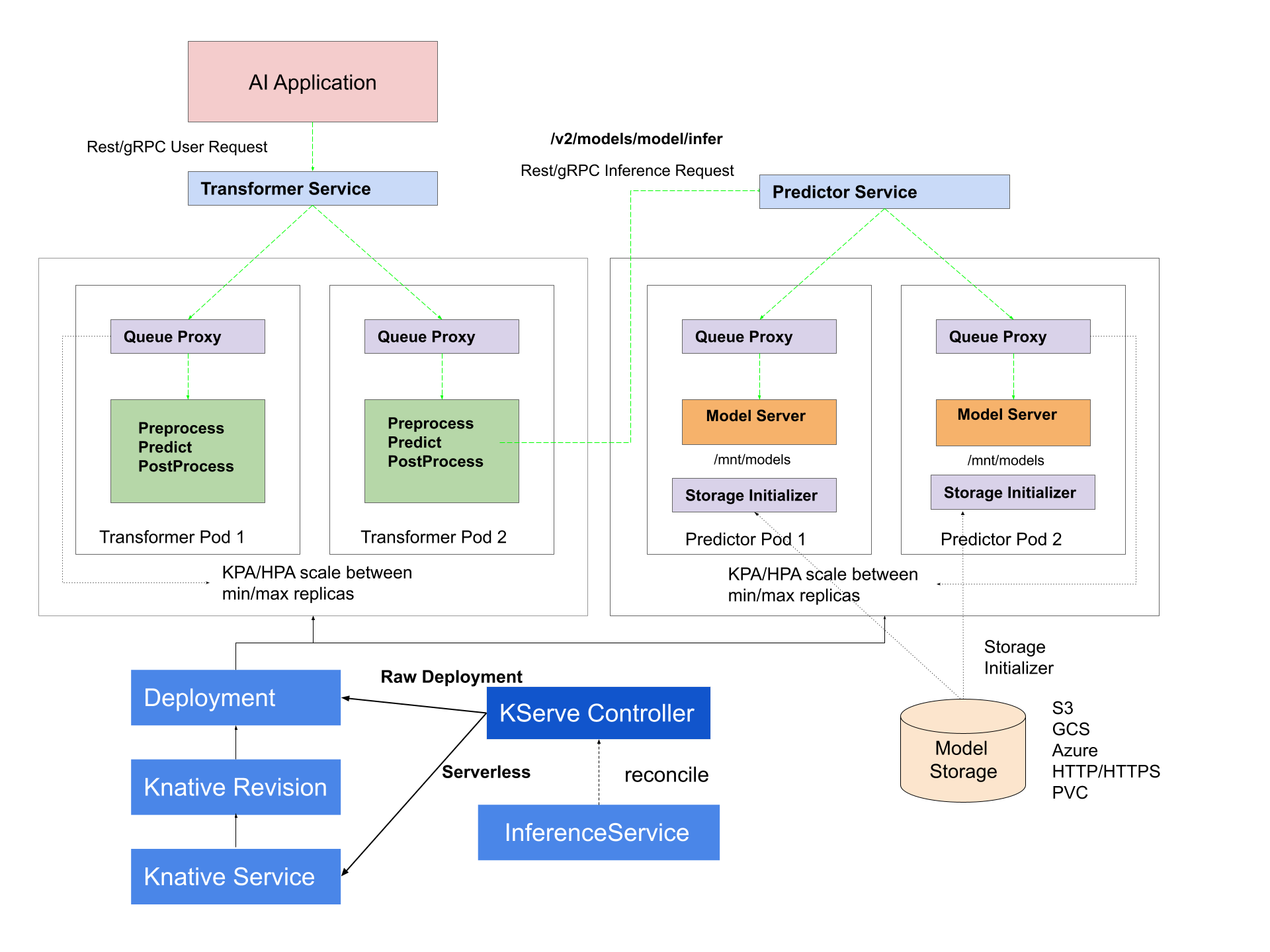

KServe是一個基于Kubernetes的機器學習模型服務框架,提供簡單的Kubernetes CRD,可用于將單個或多個經過訓練的模型(例如TFServing、TorchServe、Triton等推理服務器)部署到模型服務運行時。ModelServer和MLServer是KServe中兩個模型服務運行時,用于在KServe中部署和管理機器學習模型。KServe內置了ModelServer和MLServer兩種預定義模型服務運行時,它們能夠提供開箱即用的模型服務。ModelServer使用預測v1協議在KServe本身中實現Python模型服務運行時,MLServer使用REST和gRPC實現預測v2協議。如果需要更復雜的用例,您也可以選擇構建自己的自定義模型服務器。此外,KServe還提供基本API原語,可輕松構建自定義模型服務運行時。您也可以使用其他工具(例如BentoML)來構建您自己的自定義模型服務鏡像。

基于Knative使用InferenceService部署模型后,您將獲得以下Serverless能力:

縮容到0

基于RPS、并發數、CPU/GPU指標自動彈性

多版本管理

流量管理

安全認證

開箱即用可觀測性

KServe Controller

KServe Controller是KServe的核心組件之一,它負責管理InferenceService自定義資源,并通過創建Knative服務部署實現自動化的擴縮容,即該服務部署能根據請求流量進行自動擴縮容,并在未收到流量時會將服務的Pod縮小到零。這種自動化的擴縮容可以有效地管理模型服務的資源使用,并確保只有在需要時才會使用資源。

部署KServe

登錄容器服務管理控制臺,在左側導航欄選擇集群。

在集群列表頁面,單擊目標集群名稱,然后在左側導航欄,選擇。

在組件管理頁簽,找到KServe組件,然后單擊部署。在彈出的對話框中,單擊確定。

當組件狀態顯示為已部署,表明組件部署成功。