LLM數據處理算法提供了對數據樣本進行編輯和轉換、過濾低質量樣本、識別和刪除重復樣本等功能。您可以根據實際需求組合不同的算法,從而過濾出合適的數據并生成符合要求的文本,方便為后續的LLM訓練提供優質的數據。本文通過LLM大語言模型端到端鏈路模板,為您介紹數據處理、模型訓練和模型推理的全流程。

數據集說明

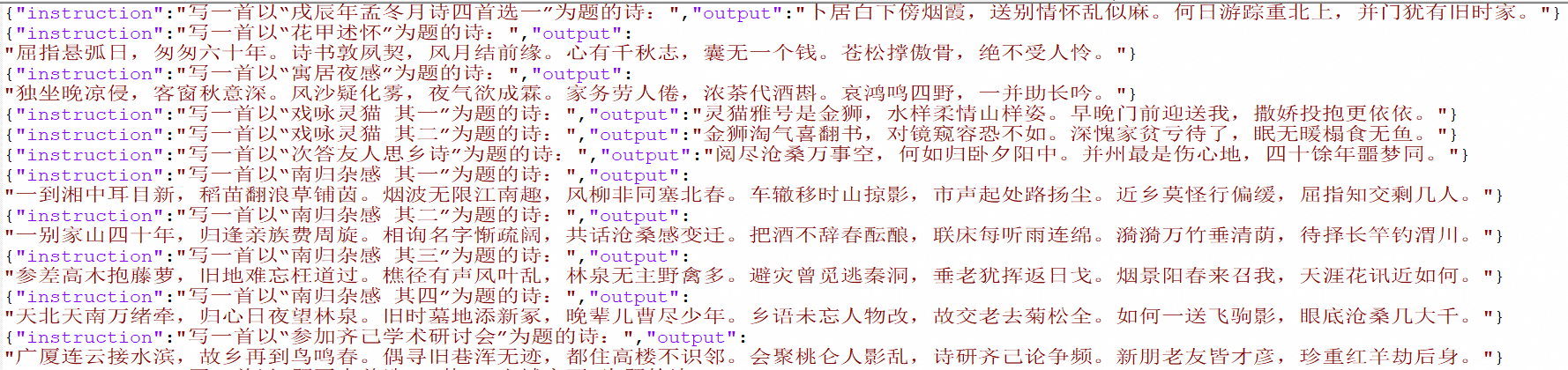

本文Designer中“LLM大語言模型端到端鏈路-DLC組件:數據處理+模型訓練+模型推理”預置模板用的數據集需遵循問答對格式,即包含問題字段instruction和答案字段output。

創建并運行工作流

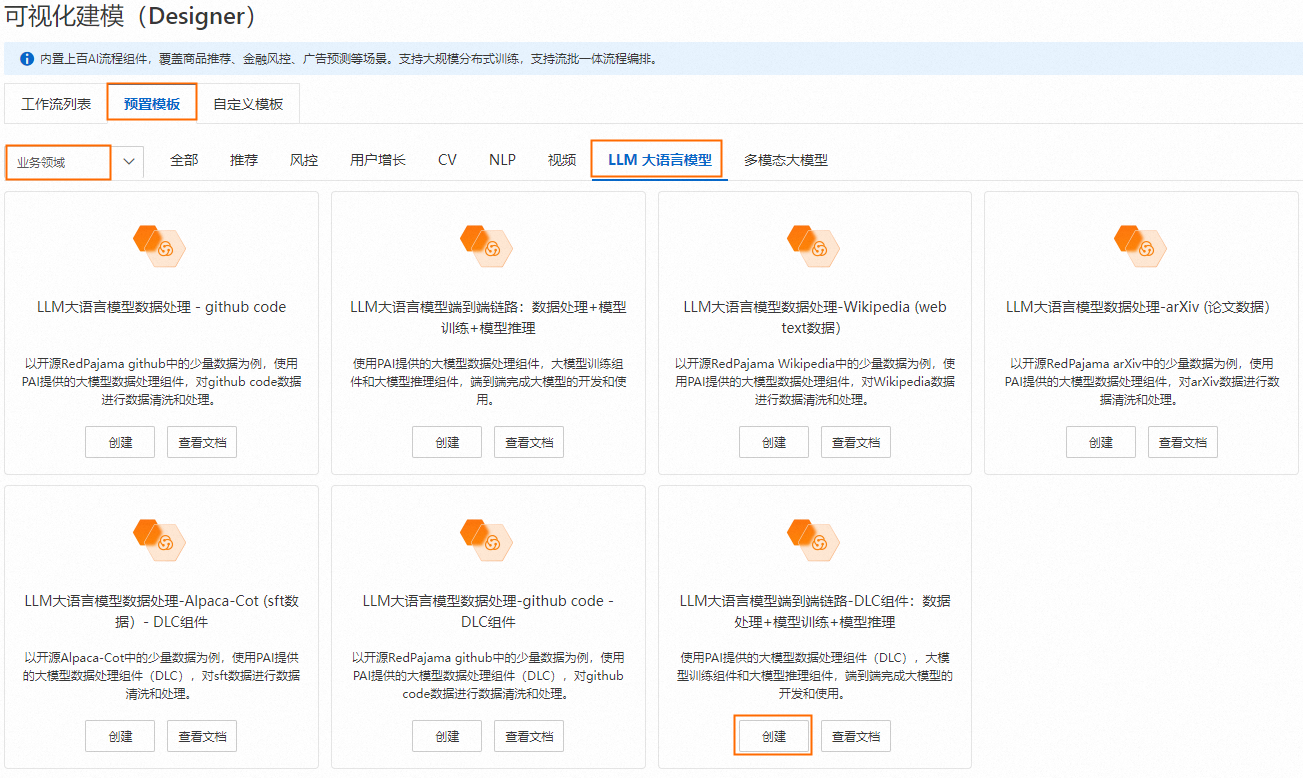

進入Designer頁面。

登錄PAI控制臺。

在頂部左上角根據實際情況選擇地域。

在左側導航欄選擇工作空間列表,單擊指定工作空間名稱,進入對應工作空間。

在左側導航欄選擇模型開發與訓練 > 可視化建模(Designer),進入Designer頁面。

創建工作流。

在預置模板頁簽下,選擇業務領域 > LLM 大語言模型,單擊LLM大語言模型端到端鏈路-DLC組件:數據處理+模型訓練+模型推理模板卡片上的創建。

配置工作流參數(或保持默認),單擊確定。

在工作流列表,選擇已創建的工作流,單擊進入工作流。

工作流說明:

工作流中關鍵算法組件說明:

LLM-文本標準化(DLC)-1/LLM-文本標準化(DLC)-2

分別將“instruction”和“output”字段中的文本進行Unicode標準化處理,同時將繁體轉簡體。

LLM-敏感信息打碼(DLC)-1/LLM-敏感信息打碼(DLC)-2

分別將“instruction”和“output”字段中的敏感信息打碼。例如:

將郵箱地址字符替換成

[EMAIL]。將手機電話號碼替換成

[TELEPHONE]或[MOBILEPHONE]。將身份證號碼替換成

IDNUM。

LLM模型訓練

根據選擇的模型及對應訓練方式進行模型訓練。模型來源于PAI-QuickStart中,底層計算基于DLC容器任務。訓練方式需和模型對應,各模型支持的訓練方式如下:

qwen-7b:支持QLoRA、全參微調。

qwen-7b-chat:支持QLoRA、全參微調。

qwen-1_8b-chat:支持QLoRA。

llama-2-7b:支持QLoRA、全參微調。

llama-2-7b-chat:支持QLoRA、全參微調。

baichuan2-7b-base:支持QLoRA、LoRA、全參微調。

baichuan2-7b-chat:支持QLoRA、LoRA、全參微調。

chatglm3-6b:支持QLoRA、LoRA。

LLM模型離線推理

根據選擇的模型進行離線推理。

運行工作流。

運行結束后,右鍵單擊LLM模型離線推理組件,選擇查看數據 > 推理結果保存目錄(OSS),查看推理結果。

更多應用

您也可以使用經過相同預處理的數據,同時針對多個模型進行訓練和推理。例如,構建如下工作流并行地對qwen-7b-chat和llama2-7b-chat兩個模型進行微調,然后使用同一批測試數據來比較它們推理后生成的結果。

相關參考

LLM算法組件詳細說明,請參見LLM數據處理(DLC)。

LLM模型訓練與推理組件詳細說明,請參見大模型訓練和推理。